缓存的那些事儿:从原理到实践,让你的系统飞起来!

昨天在公司调试一个接口的时候,突然发现响应时间从原来的200ms飙升到了2秒多,吓得我赶紧排查问题。结果发现是Redis缓存挂了,所有请求都直接打到了数据库上。这让我想起刚入行那会儿,对缓存的理解还很浅薄,总觉得就是个"临时存储"而已。

其实缓存这个东西,远比我们想象的要复杂和有趣。今天就来和大家聊聊缓存的实现原理,从最基础的概念到具体的实现细节,保证让你对缓存有个全新的认识。

缓存到底是什么鬼?

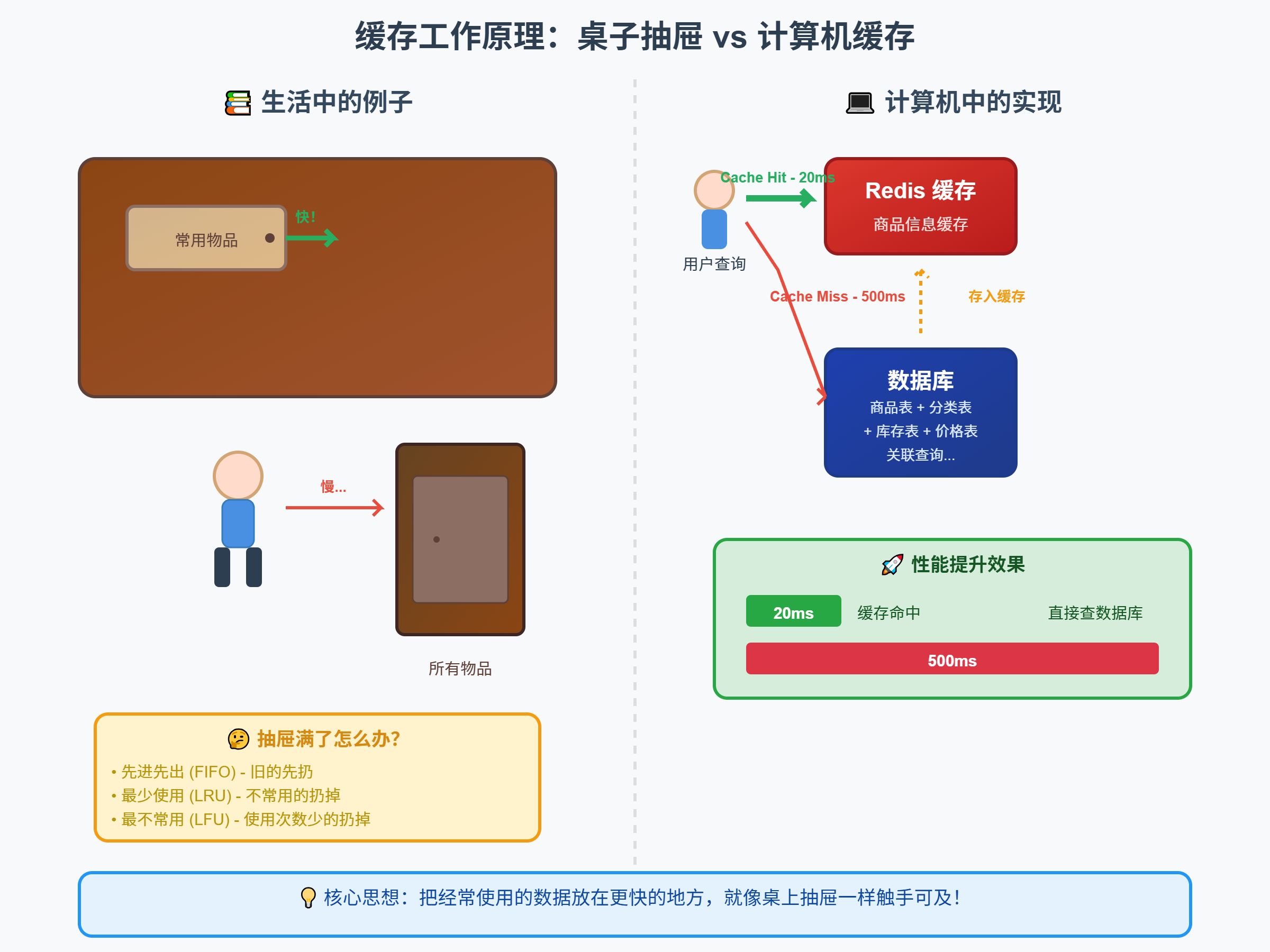

说白了,缓存就像你桌子上的那个小抽屉,经常用的东西都放在里面,用的时候直接拿就行了,不用跑到柜子里翻半天。

在计算机世界里,缓存的作用也是如此。当我们需要某个数据的时候,如果这个数据在缓存里有,我们就直接从缓存拿(Cache Hit),如果没有,就去原始数据源拿,然后顺便放一份到缓存里(Cache Miss)。

但是这里面的学问可大了去了。比如说,你的抽屉总共就那么大,新东西要往里放的时候,旧的东西怎么办?先进先出?还是把最不常用的扔掉?这就涉及到缓存的淘汰策略了。

我记得之前做过一个项目,用户查询商品信息的接口特别慢,因为每次都要关联好几张表。后来加了个Redis缓存,把查询结果存起来,接口响应时间直接从500ms降到了20ms。那种感觉,就像是给汽车装了个涡轮增压器一样爽。

CPU缓存:硬件层面的速度魔法

说到缓存,不得不提CPU缓存。这个东西可以说是整个计算机系统中最精妙的设计之一了。

CPU工作的时候需要不断地从内存读取数据,但是CPU的速度和内存的速度差距实在太大了。就好比一个跑车司机,结果路上全是红绿灯,再快的车也得等。

所以CPU里面设计了三级缓存:L1、L2、L3。L1缓存最小但最快,通常只有几十KB,分为指令缓存和数据缓存。L2缓存稍大一些,一般几百KB到几MB。L3缓存最大,可能有几十MB,而且是多个CPU核心共享的。

这个设计的巧妙之处在于,它利用了程序的局部性原理。什么意思呢?就是说程序在某个时间段内,往往会反复访问同一块内存区域的数据(空间局部性),或者刚刚访问过的数据很可能在短时间内再次被访问(时间局部性)。

举个例子,当你遍历一个数组的时候,CPU会把整个数组的一部分都加载到缓存里,这样后面访问相邻元素的时候就不用再去内存拿了。这就是为什么循环遍历数组比随机访问要快得多的原因。

我之前优化过一个排序算法,就是利用了这个特性。原来的代码随机访问数据,缓存命中率很低,后来改成顺序访问,性能提升了好几倍。

内存管理中的缓存策略

操作系统的内存管理也大量使用了缓存思想。最典型的就是页缓存(Page Cache)。

当程序读取文件的时候,操作系统不会直接去磁盘读,而是先看看页缓存里有没有。如果有,直接返回;如果没有,就从磁盘读取,然后放到页缓存里。写文件的时候也是类似,先写到页缓存,然后异步地刷到磁盘上。

这样做的好处显而易见:磁盘IO是很慢的,如果每次读写都直接操作磁盘,系统性能会差得一塌糊涂。有了页缓存,大部分情况下都能命中缓存,大大提高了系统的整体性能。

不过这里有个问题,就是内存是有限的,不可能把所有文件都缓存起来。所以操作系统需要一套淘汰策略来决定哪些页面应该被换出。Linux用的是一种近似LRU的算法,具体实现还挺复杂的,涉及到活跃链表和非活跃链表什么的。

我曾经遇到过一个很有意思的问题,服务器上有个程序每天凌晨会读取一个几十GB的日志文件进行分析。结果发现这个程序运行的时候,其他程序都变得很慢。后来才发现是因为这个大文件把页缓存给"污染"了,把其他有用的缓存都挤出去了。解决办法是在读取大文件的时候使用O_DIRECT标志,绕过页缓存直接读取磁盘。

数据库缓存的精妙设计

数据库的缓存设计可以说是最复杂也最有趣的。因为数据库不仅要考虑读性能,还要保证数据的一致性和持久性。

最核心的就是Buffer Pool。这个东西就像是数据库的"工作台",所有的数据页都要先加载到Buffer Pool里才能被操作。当你执行一个SELECT查询的时候,数据库首先会检查需要的数据页是否已经在Buffer Pool里了。如果在,直接使用;如果不在,就从磁盘读取到Buffer Pool里。

但是这里有个难点:数据是会被修改的。如果一个数据页在Buffer Pool里被修改了,那它就和磁盘上的版本不一致了,这叫做"脏页"。数据库需要在合适的时候把这些脏页写回磁盘,这个过程叫做"刷脏"。

MySQL的InnoDB引擎在这方面做得特别巧妙。它有个后台线程专门负责刷脏页,而且会根据系统的负载情况动态调整刷脏的频率。负载高的时候少刷一点,避免影响正常的查询;负载低的时候多刷一点,保证数据的安全性。

除了Buffer Pool,数据库还有很多其他类型的缓存。比如查询缓存,会把SELECT语句和对应的结果存起来,下次再执行相同的查询就直接返回结果。不过这个功能在MySQL 8.0里被移除了,因为维护成本太高,而且命中率往往不高。

我记得之前调优一个数据库的时候,发现Buffer Pool的命中率只有60%多,查询性能很差。后来分析发现是Buffer Pool配置得太小了,增大之后命中率提升到95%以上,查询速度快了好几倍。

分布式缓存的挑战与解决方案

单机缓存虽然快,但是容量有限,而且在分布式系统中没法共享。所以就有了分布式缓存,最典型的就是Redis和Memcached。

Redis的内部实现其实挺有意思的。它使用了一种叫做"字典"的数据结构来存储键值对,底层是个哈希表。但是普通的哈希表有个问题,就是扩容的时候需要重新计算所有元素的位置,这会阻塞整个操作。

Redis的解决办法是渐进式哈希。它维护两个哈希表,扩容的时候新的元素放到新表里,旧的元素逐步迁移到新表。这样就避免了一次性重新计算所有元素带来的性能问题。

还有一个有意思的地方是Redis的内存管理。Redis会对存储的对象进行各种优化,比如小整数会用特殊的编码方式存储,字符串会根据长度选择不同的存储策略。这些优化看起来很小,但是在大规模应用中能节省大量内存。

分布式缓存还有个挑战是数据一致性。当后端数据发生变化的时候,缓存里的数据可能就过时了。最简单的办法是设置过期时间,让缓存自动失效。但是这样可能会导致缓存穿透,就是大量请求同时发现缓存过期,都去查询后端数据源,把数据库给打垮了。

我们项目里用的是一种叫做"缓存预热"的策略。在缓存即将过期的时候,后台任务会提前去更新缓存,这样用户请求过来的时候总是能命中缓存。当然,这样做的前提是你能预测哪些数据会被经常访问。

缓存淘汰算法的艺术

缓存的空间总是有限的,所以当缓存满了的时候,就需要淘汰一些数据来为新数据腾出空间。这里面的学问可大了。

最简单的是FIFO(先进先出),就像排队一样,先进来的先出去。但是这个算法有个明显的缺点:它不考虑数据的使用频率,可能会把经常使用的数据给淘汰掉。

更常用的是LRU(最近最少使用)。这个算法的思想是,最近使用过的数据在未来被使用的可能性更大,所以优先淘汰最长时间没有被使用的数据。

LRU的实现通常用链表+哈希表。哈希表用来快速定位数据,链表用来维护使用顺序。每次访问一个数据的时候,就把它移动到链表头部;需要淘汰的时候,就从链表尾部移除。

但是LRU也有问题。比如说,如果有个大的数据集只被扫描一次,就会把缓存里其他有用的数据都给挤出去。这叫做"缓存污染"。

为了解决这个问题,有人提出了LFU(最少使用频率)算法。这个算法不仅考虑最近性,还考虑频率。实现起来比LRU复杂一些,需要为每个数据维护一个访问计数器。

Redis支持多种淘汰策略,包括LRU、LFU,还有随机淘汰等。在实际项目中,我一般会根据业务特点来选择。如果数据的访问模式比较随机,用LRU;如果有明显的热点数据,用LFU效果会更好。

我之前遇到过一个案例,系统的缓存命中率一直不高,后来发现是因为有个定时任务会扫描大量历史数据,把正常的热点数据都给挤出去了。最后的解决办法是给这个定时任务单独搭建一套缓存系统,避免相互影响。

Web应用中的多层缓存

在Web应用中,缓存往往是分层的。从用户的角度看,一个请求可能会经过浏览器缓存、CDN缓存、反向代理缓存、应用层缓存、数据库缓存等多个层次。

浏览器缓存是最接近用户的,主要通过HTTP头部来控制。比如Cache-Control、Expires等。这个缓存对于静态资源特别有效,像CSS、JS、图片什么的,可以直接从浏览器缓存读取,连网络请求都不用发。

CDN缓存把内容分发到全球各地的节点上,用户请求的时候从最近的节点获取内容。这对于静态内容的加速效果特别明显。我们公司的官网用了CDN之后,海外用户的访问速度提升了好几倍。

应用层缓存是我们开发者最能控制的。可以在代码里实现各种缓存逻辑,比如把数据库查询结果缓存起来,或者把计算结果缓存起来。

我之前做过一个数据分析的项目,用户经常查询各种统计报表。这些报表的计算很复杂,每次都要跑好几分钟。后来我们把计算结果按照查询条件做了缓存,第二次查询相同条件的时候直接返回结果,用户体验好了很多。

不过多层缓存也带来了一些问题,主要是一致性的问题。当底层数据发生变化的时候,需要让所有相关的缓存都失效,这个协调工作还挺复杂的。

缓存一致性的那些坑

说到缓存一致性,这绝对是个让人头疼的问题。理论上很简单:当数据更新的时候,把相关的缓存也更新或者删除掉就行了。但是实际操作起来,坑多得你想象不到。

最常见的是"双写不一致"问题。比如说,你先更新了数据库,然后更新缓存。但是如果在这个过程中有其他线程也在操作相同的数据,就可能导致缓存和数据库的数据不一致。

还有一种情况是"缓存穿透"。如果有恶意用户故意查询不存在的数据,这些请求就会绕过缓存直接打到数据库上。如果请求量很大,就可能把数据库打垮。

解决办法有几种。一种是"缓存空值",就是把查询结果为空的情况也缓存起来,只是设置一个比较短的过期时间。另一种是"布隆过滤器",可以快速判断一个数据是否可能存在,如果布隆过滤器说不存在,那就肯定不存在,可以直接返回。

"缓存雪崩"也是个要命的问题。如果大量缓存同时过期,就会有大量请求同时打到数据库上。我们通常的做法是在过期时间上加个随机值,让缓存的过期时间分散一些。

我记得有一次生产环境就遇到了缓存雪崩。当时是凌晨做了一次数据更新,清空了所有相关的缓存。结果第二天早上用户一上班,大量请求涌入,数据库直接撑不住了。后来我们改成了分批清理缓存,避免了这个问题。

现代缓存系统的发展趋势

最近几年,缓存技术也在不断演进。有几个趋势特别值得关注。

第一个是"智能缓存"。传统的缓存系统基本上是被动的,只是简单地存储和淘汰数据。但是现在有一些系统开始引入机器学习算法,可以预测哪些数据会被访问,提前加载到缓存里。

第二个是"分层存储"。现在的服务器往往同时配备了内存、SSD、机械硬盘等不同速度的存储设备。智能的缓存系统可以根据数据的访问频率,自动把数据放到合适的存储层次上。

第三个是"边缘计算"。随着5G和物联网的发展,越来越多的计算和缓存被推到网络边缘。这样可以减少网络延迟,提供更好的用户体验。

我最近在研究一个叫做"自适应缓存"的技术,它可以根据当前的访问模式自动调整缓存策略。比如说,如果检测到当前是顺序访问模式,就会增加预加载;如果是随机访问模式,就会更注重热点数据的保留。感觉这个方向很有前景。

缓存在不同场景下的应用

不同的业务场景对缓存的需求也不一样。电商系统更注重商品信息的快速查询,社交系统更注重时间线的实时更新,搜索系统更注重索引的快速访问。

在电商系统中,商品信息、用户信息、购物车这些都是典型的缓存场景。但是这里面有个特点,就是读多写少,而且对一致性要求不是特别严格。所以可以使用比较激进的缓存策略,比如设置较长的过期时间。

社交系统就不一样了。用户的时间线需要实时更新,而且个性化程度很高。这种场景下,缓存的设计就要更加灵活。我见过一种设计是把用户的时间线分段缓存,新的动态来了只需要更新最新的那一段。

搜索系统的缓存更复杂。不仅要缓存搜索结果,还要缓存各种索引信息。而且搜索查询的组合非常多,缓存的命中率往往不高。所以搜索系统通常会使用多级缓存,把不同粒度的数据分别缓存。

我之前参与过一个视频网站的开发,视频的元数据(标题、描述、时长等)访问频率很高,但是视频文件本身很大,不可能全部放到内存里。我们的解决方案是把元数据放到Redis里,视频文件放到CDN上,热门视频的一小段会放到边缘服务器的SSD上。这样既保证了访问速度,又控制了成本。

最后

缓存这个东西,说简单也简单,说复杂也复杂。简单的地方在于基本思想很直观:把经常用的数据放在快速存储里。复杂的地方在于实际应用中要考虑的因素太多了:一致性、可用性、性能、成本等等。

从CPU的多级缓存到分布式的Redis集群,从简单的LRU算法到复杂的自适应策略,缓存技术一直在演进。作为开发者,我们需要理解这些底层原理,才能在实际项目中做出正确的设计决策。

不过话说回来,再好的缓存策略也不能解决所有问题。有时候性能瓶颈可能在别的地方,比如数据库查询优化、网络传输、代码逻辑等等。缓存只是性能优化工具箱里的一个工具,要配合其他技术一起使用才能发挥最大效果。

我觉得学习缓存最好的方法就是多实践。可以自己搭建一个Redis环境,试试不同的数据结构和淘汰策略,看看它们在不同场景下的表现。也可以在自己的项目里加入一些缓存逻辑,观察对性能的影响。

缓存的世界很精彩,希望这篇文章能给你一些启发。如果你在实际工作中遇到了缓存相关的问题,欢迎留言讨论。

如果觉得这篇文章对你有帮助的话,不妨点个赞转发一下,让更多的朋友看到。我是@运维躬行录,专注分享实用的技术干货,关注我,一起在技术的道路上成长!