让 AI 直接接管我的 Linux 终端?Open Interpreter 深度实操,这玩意儿真能让我少熬夜!

说真的,最近这段时间,我一直在想一个事儿。咱们干运维的,天天跟那一堆黑框框打交道,写不完的 Shell 脚本,调不完的 Python 自动化,有时候为了抓一个日志里的异常,在那儿 awk、sed、grep 半天,最后发现还是正则表达式少写了一个反斜杠。我就在想,这 AI 都能写代码了,能不能更进一步?能不能我动动嘴,它直接在我机器上把活儿给干了?

别跟我提 ChatGPT 那个网页版,我知道它能写代码,但我还得复制、粘贴,然后再手动到服务器上去跑,跑出报错了,我还得把报错贴回去给它看,这来回折腾的过程,说实话,挺磨人的。

直到我遇到了 Open Interpreter。

这东西刚出来的时候我就关注了,当时觉得也就那样,可能就是个噱头。但最近深度用了两周,我发现我错了,这玩意儿简直就是个“有手的 GPT”。它不只是给你写代码,它是真的能直接控制你的电脑,进你的目录,删你的垃圾文件,甚至还能帮你给服务器换个壁纸(虽然咱们生产环境不干这事儿)。

今天我就想跟大家好好唠唠这东西,不整那些虚头巴脑的 PPT 概念,咱就从实战出发,看看这玩意儿到底能不能帮咱这群“搬砖的”省点心。

这东西到底是干啥的?

项目地址:https://github.com/openinterpreter/open-interpreter/blob/main/docs/README_ZH.md

简单来说,Open Interpreter 就是一个本地版的“代码解释器”。大家都知道 ChatGPT 有个 Code Interpreter 插件,但那是跑在 OpenAI 云端的沙箱里的。你不能让它帮你改你电脑里的配置文件,对吧?

Open Interpreter 就不一样了。它是在你本地跑的,你给它一句话,它会自己琢磨:第一步该干啥,第二步该写什么代码,写完了直接在你的命令行里“砰”地一下跑出来。如果你没给它授权自动执行,它还会乖乖地问你:“老板,这行 rm -rf / 我能跑吗?”(开个玩笑,它一般没这么虎,但也得留神)。

我觉得它最牛的地方在于,它打通了自然语言和系统底层。比如我说:“帮我把当前目录下所有大于 100M 的日志文件找出来,压缩一下,然后把原文件删了。”

以前我得写个 find 加 xargs 加 tar 的长串命令,万一路径里有个空格,还得翻车。现在?我直接把这要求敲进去,它就开始一顿操作,我看戏就行。

咱们先得把这尊佛给请进来

先说说安装吧,别看官方文档写得简单,真装起来还是有点小坑。

我建议大家,千万别直接往系统 Python 环境里怼。Python 环境那点破事儿大家又不是不知道,这个库依赖版本高了,那个库版本低了,最后搞得整个系统环境乱七八糟。

先整一个虚拟环境,我是习惯用 conda:

conda create -n interpreter_env python=3.10

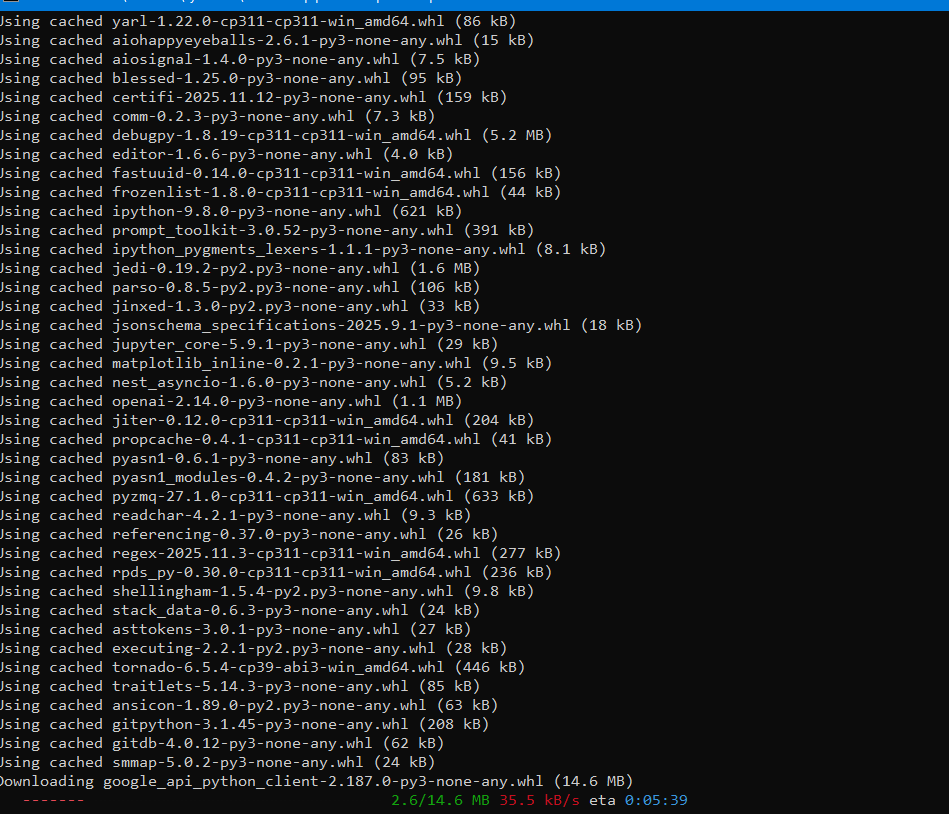

conda activate interpreter_env然后就是一句话:pip install open-interpreter

装完之后,你在终端敲个 interpreter,它就出来了。

不过这里有个关键点,也是很多人卡住的地方——这玩意儿默认是要连 OpenAI 的。你需要一个 OPENAI_API_KEY。如果你像我一样,有些内网环境或者舍不得那点 Token 钱,它其实支持本地模型。你可以搭配 Ollama 跑 Llama 3,或者是用 LM Studio 之类的。但我得说实话,本地小模型的智商有时候确实感人,如果你想让它处理复杂的逻辑,还是建议咬咬牙用 GPT-4 的 API,那逻辑清晰得简直不像话。

实战场景一:再也不想写那些该死的日志分析脚本了

咱们运维日常最多的活儿是啥?查日志啊!

前两天我那台 Nginx 负载突然飙升,满屏幕的 Access Log,我当时正急着去吃饭。要是以前,我得在那儿 cat access.log | awk '{print $1}' | sort | uniq -c | sort -nr | head -n 10。

我直接打开 Open Interpreter:

“帮我分析一下 access.log,看看请求量最高的前 10 个 IP 是哪些,顺便查一下这些 IP 是不是国内的,把结果存成一个 Markdown 表格。”

它先是回了我一句:“没问题,我先用 Python 读取一下文件开头看下格式。”

然后它自己写了段 Python,用了 pandas 和 requests。过了一会儿,它说它没装 pandas,它居然自己提了一句:“我需要安装 pandas 库,可以吗?”

我敲了个 y。

它自己装好,跑完,把表格啪地一下甩在我脸上。前后不到一分钟,我连烟都没点着。

这就是我觉得它最接地气的地方:它有自我修正能力。代码跑错了?它自己看报错信息,自己改。这不就是我们平时干的活儿吗?只不过它动作比我们快得多。

关于安全性的碎碎念

我知道,肯定有人要问:“你把终端权限给 AI,你心这么大吗?”

确实,这事儿一开始我也打鼓。万一它一个脑抽,把 /etc/ 给我扬了怎么办?

所以 Open Interpreter 有个默认模式,每执行一行代码都要你确认。虽然繁琐点,但那是保命的。

等你真玩熟了,或者是在一个无关紧要的测试机上,你可以加个 -y 参数,让它“自生自灭”。

但我建议啊,尤其是咱们在生产环境或者是存有重要数据的机器上,千万别开 -y。AI 这玩意儿有时候会产生幻觉,它觉得这个命令能优化性能,结果可能是把你数据库给停了。

有次我让它帮我优化一下磁盘空间,这家伙上来就想删我的 Docker 镜像,吓得我赶紧 Ctrl+C。所以,它是个好助手,但你得是那个拿主意的“总监”。

实战场景二:批量处理文件的痛苦消失了

再举个例子,办公自动化的活儿。

有一次老板扔给我一堆 PDF,全是服务器的巡检报告,文件名乱七八糟的,有的是日期开头,有的是主机名开头。他让我统一重命名成 日期-主机名-巡检.pdf 的格式,还得把里面提到“异常”的报告挑出来。

这活儿技术含量不高,但极其烦人。

我直接跟 Open Interpreter 说:

“去 reports 文件夹里,读取每个 PDF 的内容。提取里面的日期和主机名,重命名文件。如果内容里包含‘Critical’或者‘Error’字样,就把这些文件复制到 error_reports 文件夹里。如果你需要处理 PDF 的库,你自己装。”

它说:“好嘞,我打算用 PyPDF2。”

然后它发现有的 PDF 是扫描件,读取不到文字,它又跟我商量:“老板,有些读不出来,要不我试试 OCR?”

那一刻,我真觉得这东西有点灵魂在里面。虽然最后有些 OCR 还是没搞定(毕竟本地算力有限),但这种互动感真的比写死板的脚本强太多了。

深度进阶:本地离线也能玩?

很多哥们儿在内网干活,没法连外网。这时候 Open Interpreter 的本地模式就派上用场了。

你可以配合 Ollama 玩。先在机器上装好 Ollama,拉个 llama3 或者 qwen 之类的模型。

然后运行:interpreter --local

它会让你选模型。说实话,用本地模型的时候,响应速度取决于你的显卡或者 CPU。如果你用的是那种没显卡的破服务器,那建议还是算了,等它憋出一个命令来,你早手写完了。但如果你手里有个 Mac M2 或者带 3060 以上显卡的机器,那体验还是不错的。

不过本地模型有个毛病,就是“不听话”。有时候它会陷入死循环,或者在那儿废话连篇。这时候你就得调优它的 System Prompt,或者是在提问的时候尽可能明确。

比如,别说“帮我查系统状态”,要说“请使用 top 和 free -m 命令查看系统状态,并给出具体的 CPU 和内存占用百分比”。你给的指令越具体,它跑偏的概率就越小。

这玩意儿的逻辑其实有点“跳跃”

大家用的时候可能会发现,Open Interpreter 的逻辑有时候不像程序那样死板,反而有点像咱们人。

它会先尝试一种方法,不行就换一种。

记得有次我让它帮我写一个监控脚本,它先是用 Python 的 psutil 库,结果发现没权限。它没跟我死磕,直接转手写了一个 Shell 脚本去读 /proc 目录。

这种“不撞南墙不回头,撞了南墙赶紧溜”的劲儿,确实挺有意思。

但也因为这种跳跃,有时候它会把你的目录弄得有点乱。因为它可能会为了测试某个功能,临时建一堆 test.py、temp.txt。所以建议大家在一个专门的工作目录下运行它,或者是定期让它自己“打扫战场”。

我就经常在结束对话前加一句:“把我刚才让你建的那些乱七八糟的临时文件全删了。”

它会很听话地去执行 rm。

一些零散的坑和心得

- 权限问题:如果你不以

sudo运行,很多系统级别的操作它干不了。但如果你给了它sudo,那你就是把家钥匙直接挂在门口了。我的折中方案是,普通任务普通用户跑,涉及系统配置的,我盯着它,手动输入密码。 - 网络环境:如果你用 OpenAI 的 API,记得挂好代理。这东西对网络的依赖挺强的,一旦断线,它那边的上下文可能就丢了,又得从头解释一遍。

- 多轮对话:它是有记忆的。你可以先让它列出文件,然后再说“把刚才列出的第三个删了”。它记得住,这点很关键。

- 不要过度依赖:它能帮你处理 80% 的体力活,但剩下的 20% 核心决策,还得你来。它写出的代码,哪怕再完美,你也得扫一眼,这是运维的基本素养。

写在最后

蒸汽的轰鸣让挥舞千年的马鞭凝固半空,晶体管的微光让拨动了几个世纪的算盘珠成了案头的摆件;这不再是“换一把更快的刀”,而是“直接降下了一场重塑山河的雷雨”。它把我们从那些低头的、琐碎的、甚至有些卑微的语法纠缠中硬生生地拎了出来,它让我们猛然发现,原来进入未来的入场券,不在于你手里握着多么纯熟的旧工具,而在于你是否敢于丢掉那根已经发霉的马鞭,去握住那级从未见过的方向盘。未来已来,在你放下对“马鞭”执念的那一刻,它已经越过了你的肩膀,直接接管了你眼前的光标。

码字不易,要是觉得这篇实战分享对你有那么一丁点启发,别忘了点个赞,转给身边还在苦哈哈写脚本的哥们儿。

大家有什么好玩的用法,或者在安装配置时踩到的坑,欢迎在评论区里留言,咱们互相交流,共同避坑。

关注我,带你玩转不一样的运维技术。

公众号:运维躬行录

个人博客:躬行笔记