Python sh库:让运维脚本告别subprocess的痛苦,一行代码搞定系统命令

最近在整理服务器监控脚本的时候,发现自己写的代码里到处都是subprocess.Popen(),看着就头疼。想起刚入行那会儿,为了执行个简单的ls命令,愣是写了十几行代码处理各种异常和输出,现在想想真是太蠢了。

直到遇到了Python的sh库,我才发现原来执行系统命令可以这么优雅。今天就来聊聊这个让我爱不释手的库,相信看完之后你也会和我一样,再也不想碰subprocess了。

为什么我会选择sh库

说实话,Python标准库里的subprocess功能很强大,但用起来真的很繁琐。每次想执行个简单命令都要考虑一堆问题:怎么获取输出?怎么处理错误?怎么传参数?

import subprocess

# 传统的subprocess写法,光看着就累

result = subprocess.run(['ls', '-la'],

capture_output=True,

text=True,

check=True)

print(result.stdout)

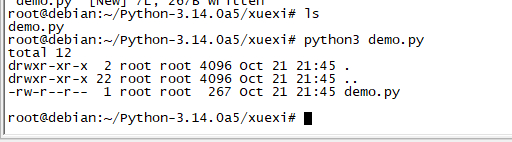

而用sh库呢?

import sh

print(sh.ls('-la'))就这么简单!一行代码搞定,看着就舒服多了。

sh库的安装和基本使用

安装很简单,pip一下就行:

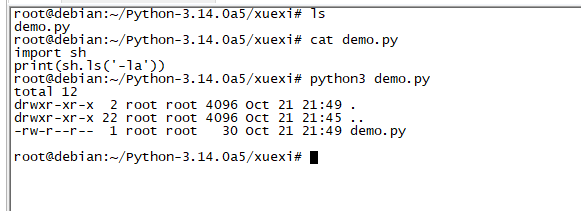

pip install sh基本使用更简单,直接把系统命令当成Python函数调用就可以了:

import sh

# 执行ls命令

print(sh.ls())

# 带参数的命令

print(sh.ls('-la', '/home'))

# 管道操作也很简单

print(sh.grep(sh.ps('aux'), 'python'))我第一次看到这种写法的时候,真的被震撼到了。这不就是我一直想要的那种简洁的方式吗?

实际项目中的应用场景

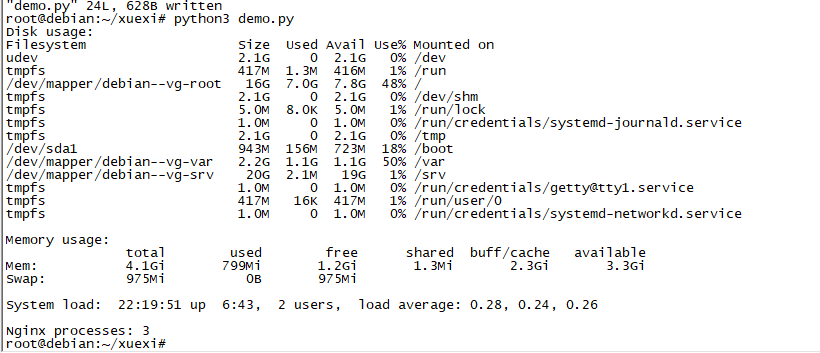

在我日常运维中,sh库真的帮了大忙。比如说服务器健康检查脚本:

import sh

from datetime import datetime

def check_server_status():

# 检查磁盘使用情况

disk_usage = sh.df('-h')

print(f"磁盘使用情况:\n{disk_usage}")

# 检查内存使用

memory_info = sh.free('-h')

print(f"内存使用情况:\n{memory_info}")

# 检查CPU负载

load_avg = sh.uptime()

print(f"系统负载:{load_avg}")

# 检查特定进程

try:

nginx_processes = sh.pgrep('nginx')

print(f"Nginx进程数:{len(nginx_processes.strip().split())}")

except sh.ErrorReturnCode_1:

print("警告:Nginx进程未运行!")

这种写法比subprocess清爽太多了,而且代码可读性特别好。

处理命令输出和错误

sh库在处理命令输出方面也很贴心:

import sh

# 获取命令输出

output = sh.ls('/home')

print(type(output)) # <class 'sh.RunningCommand'>

print(str(output)) # 转换为字符串

# 实时处理输出

def process_line(line):

print(f"处理行: {line.strip()}")

sh.tail('-f', '/var/log/syslog', _out=process_line)错误处理也很直观:

import sh

try:

# 执行可能失败的命令

result = sh.ls('/nonexistent')

except sh.ErrorReturnCode_2 as e:

print(f"命令执行失败: {e}")

print(f"错误输出: {e.stderr}")

print(f"标准输出: {e.stdout}")

print(f"退出码: {e.exit_code}")高级功能:管道和重定向

sh库对管道的支持让我印象深刻,写起来就像在shell里一样自然:

import sh

# 管道操作

result = sh.ps('aux') | sh.grep('python') | sh.wc('-l')

print(f"Python进程数量: {result}")

# 更复杂的管道

log_errors = sh.tail('-n', '1000', '/var/log/app.log') | sh.grep('ERROR')

print(log_errors)

# 重定向到文件

sh.dmesg(_out='/tmp/dmesg.log')

# 从文件读取输入

sh.sort(_in='/tmp/unsorted.txt', _out='/tmp/sorted.txt')这种写法真的很接近shell脚本的感觉,但又保持了Python的灵活性。

在自动化部署中的应用

我们团队的自动化部署脚本大量使用了sh库,效果很不错:

import sh

import os

def deploy_application(app_name, version):

print(f"开始部署 {app_name} 版本 {version}")

# 停止服务

try:

sh.systemctl('stop', app_name)

print("服务已停止")

except sh.ErrorReturnCode:

print("服务停止失败,继续部署...")

# 备份当前版本

backup_dir = f"/backup/{app_name}-{datetime.now().strftime('%Y%m%d_%H%M%S')}"

sh.mkdir('-p', backup_dir)

sh.cp('-r', f'/opt/{app_name}', backup_dir)

print(f"已备份到 {backup_dir}")

# 下载新版本

download_url = f"https://releases.example.com/{app_name}-{version}.tar.gz"

sh.wget(download_url, '-O', f'/tmp/{app_name}-{version}.tar.gz')

# 解压和部署

sh.tar('-xzf', f'/tmp/{app_name}-{version}.tar.gz', '-C', '/opt/')

# 更新配置文件权限

sh.chown('-R', 'app:app', f'/opt/{app_name}')

sh.chmod('-R', '755', f'/opt/{app_name}')

# 启动服务

sh.systemctl('start', app_name)

sh.systemctl('enable', app_name)

# 验证部署

try:

status = sh.systemctl('is-active', app_name)

if 'active' in str(status):

print("部署成功!")

else:

print("部署可能有问题,请检查服务状态")

except sh.ErrorReturnCode:

print("服务启动失败!")日志分析的实际应用

在日志分析方面,sh库也表现得很出色(看看就行,都用python了,谁还这样分析呀!!!):

import sh

from collections import defaultdict

import re

def analyze_nginx_logs(log_file):

# 分析访问最多的IP

top_ips = sh.awk('{print $1}', log_file) | sh.sort() | sh.uniq('-c') | sh.sort('-nr') | sh.head('-10')

print("访问最多的IP地址:")

print(top_ips)

# 分析状态码分布

status_codes = sh.awk('{print $9}', log_file) | sh.sort() | sh.uniq('-c')

print("\n状态码分布:")

print(status_codes)

# 分析最耗时的请求

slow_requests = sh.awk('$NF > 1.0 {print $0}', log_file) | sh.sort('-k11', '-nr') | sh.head('-20')

print("\n响应时间超过1秒的请求:")

print(slow_requests)

# 统计每小时的请求量

hourly_stats = sh.awk('{print $4}', log_file) | sh.cut('-c14-15') | sh.sort() | sh.uniq('-c')

print("\n每小时请求量统计:")

print(hourly_stats)

# 使用示例

analyze_nginx_logs('/var/log/nginx/access.log')需要注意的坑

参数传递的问题

import sh

# 错误的写法

# sh.find('/home -name "*.log"') # 这样会报错

# 正确的写法

sh.find('/home', '-name', '*.log')

# 或者使用关键字参数

sh.find('/home', name='*.log')处理包含空格的路径

import sh

# 包含空格的路径需要特别处理

path_with_spaces = "/home/user/my documents"

sh.ls(path_with_spaces) # sh库会自动处理空格长时间运行的命令

import sh

# 对于长时间运行的命令,建议设置超时

try:

result = sh.rsync('-av', '/source/', '/destination/', _timeout=3600)

except sh.TimeoutException:

print("同步超时!")与其他库的对比

说实话,除了sh库,我也用过其他一些执行系统命令的库:

subprocess vs sh

- subprocess功能更全面,但代码冗长

- sh库更简洁,但在某些复杂场景下可能不够灵活

os.system vs sh

- os.system太原始,不推荐在生产环境使用

- sh库提供了更好的错误处理和输出控制

pexpect vs sh

- pexpect适合需要交互的场景

- sh库更适合执行简单的系统命令

在容器化环境中的应用

现在容器化部署很流行,sh库在这方面也很有用:

import sh

def manage_containers():

# 列出所有运行中的容器

running_containers = sh.docker('ps', '--format', 'table {{.Names}}\t{{.Status}}')

print("运行中的容器:")

print(running_containers)

# 检查容器资源使用情况

container_stats = sh.docker('stats', '--no-stream', '--format',

'table {{.Container}}\t{{.CPUPerc}}\t{{.MemUsage}}')

print("\n容器资源使用情况:")

print(container_stats)

# 清理无用的镜像

sh.docker('image', 'prune', '-f')

print("\n已清理无用镜像")

manage_containers()总结

说了这么多,其实sh库最大的优势就是让Python代码更接近shell脚本的直觉性,同时又保持了Python的强大功能。在我的日常工作中,它已经成为了不可或缺的工具。

当然,任何工具都有其适用场景。对于简单的系统命令执行,sh库绝对是首选;但如果需要复杂的进程控制或者跨平台兼容性,可能还是需要考虑其他方案。

最重要的是,在使用任何执行系统命令的库时,都要时刻注意安全性。特别是在处理用户输入或者在生产环境中运行时,一定要做好输入验证和权限控制。

希望这篇文章能帮到正在为subprocess复杂语法而头疼的朋友们。如果你有什么好的使用技巧或者踩过的坑,也欢迎在评论区分享交流。

毕竟,工具是为了提高效率而存在的,选择最适合自己项目需求的工具才是最重要的。sh库只是众多选择中的一个,但对于大部分运维场景来说,它确实是个很不错的选择。

如果这篇文章对你有帮助,别忘了点赞转发支持一下!想了解更多运维实战经验和技术干货,记得关注微信公众号@运维躬行录,领取学习大礼包!!!我会持续分享更多接地气的运维知识和踩坑经验。让我们一起在运维这条路上互相学习,共同进步!

公众号:运维躬行录

个人博客:躬行笔记