这些年踩过的坑:WebSocket、KCP、gRPC传输协议深度解析,运维必看!

最近在优化公司的网络架构时,遇到了不少传输协议的选择问题。说实话,刚开始接触这些协议的时候我也是一头雾水,什么raw websocket、kcpgrpc、xhttp、httpupgrade...听起来就让人头大。不过经过这段时间的实践和踩坑,总算是摸清了门道。

今天就把我的经验分享给大家,希望能帮到正在为协议选择而头疼的朋友们。

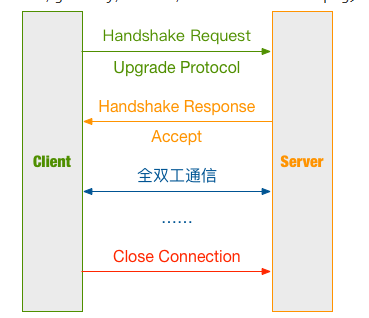

WebSocket:最直接的双向通信

先说说WebSocket吧,这个协议我用得最多。记得刚入行那会儿,项目需要实现实时聊天功能,当时技术负责人就推荐用WebSocket。

WebSocket最大的特点就是建立连接后可以双向通信,不像HTTP那样只能客户端主动请求。想象一下,HTTP就像是你去银行办业务,必须你先排队叫号,银行才能为你服务;而WebSocket就像是你和朋友打电话,双方都可以随时说话。

Raw WebSocket其实就是最原始的WebSocket实现,没有经过任何包装或优化。它的工作原理很简单:

- 客户端发起HTTP请求,请求头里带上

Upgrade: websocket - 服务器同意升级,返回101状态码

- 连接升级成功,开始WebSocket通信

我在实际使用中发现,Raw WebSocket的性能表现还是不错的。延迟低,数据传输效率高。但是有个问题,就是对网络环境要求比较高。如果网络不稳定,连接容易断开。

// 简单的WebSocket客户端示例

const ws = new WebSocket('ws://localhost:8080');

ws.onopen = function() {

console.log('连接建立');

ws.send('Hello Server');

};

ws.onmessage = function(event) {

console.log('收到消息:', event.data);

};不过在实际部署时要注意,很多企业防火墙对WebSocket支持不太友好。我就遇到过客户那边防火墙把WebSocket连接给拦截了,最后只能改用其他方案。

KCP协议:为速度而生的传输利器

详细请看这篇:https://luyuhuang.tech/2020/12/09/kcp.html

KCP这个协议说起来还挺有意思,最初是为了解决游戏行业的网络延迟问题而设计的。你知道的,玩游戏最怕什么?卡顿!特别是竞技类游戏,哪怕多100毫秒的延迟都可能影响胜负。

我第一次接触KCP是在优化一个实时监控系统的时候。当时用的TCP,虽然可靠,但是一旦网络出现丢包,TCP的重传机制就会导致延迟飙升。有时候一个包丢了,后面的包都得等着,这就是TCP的队头阻塞问题。

KCP的设计思路完全不同。它基于UDP协议,但在UDP的基础上实现了自己的可靠传输机制。简单说,KCP就是"用空间换时间"的典型代表。

KCP有几个核心特性让我印象深刻:

快速重传机制:TCP丢包后要等3个重复ACK才重传,KCP可以设置成丢包后立即重传。我在配置时通常会设置resend=2,意思是收到2个重复ACK就重传,比TCP快了一倍。

选择性重传:TCP是累积确认,一个包丢了后面的包都要重传。KCP支持选择性重传,只重传真正丢失的包。这个特性在网络质量不好的时候特别有用。

无拥塞控制:这个有点激进,TCP会根据网络状况调整发送速度,KCP可以选择关闭拥塞控制,全速发送。当然这样会增加网络负担,但延迟确实低。

// KCP的核心配置参数

ikcp_nodelay(kcp, 1, 10, 2, 1);

// 参数1: nodelay,0不启用,1启用

// 参数2: interval,内部处理时间间隔,单位毫秒

// 参数3: resend,快速重传模式,2表示2次ACK跨越将会直接重传

// 参数4: nc,是否关闭拥塞控制,0代表不关闭,1代表关闭我在实际测试中发现,KCP在弱网环境下的表现真的很出色。比如模拟5%丢包率的网络环境,TCP的延迟会波动很大,有时候能达到几秒;而KCP基本能保持在100毫秒以内。

不过KCP也不是万能的。首先是CPU占用会高一些,因为要做更多的包处理工作。其次是带宽消耗大,为了保证低延迟,KCP会发送更多的冗余数据。我测试过,同样的数据量,KCP的带宽消耗大概是TCP的1.2-1.5倍。

还有一个要注意的是,KCP基于UDP,很多企业防火墙对UDP不太友好。我就遇到过客户那边把UDP端口全部封了,最后只能改方案。

KCP的调优也是个技术活。不同的网络环境需要不同的参数配置。我一般会根据网络延迟和丢包率来调整:

- 延迟敏感的场景:nodelay=1, interval=10, resend=2, nc=1

- 带宽敏感的场景:nodelay=0, interval=40, resend=0, nc=0

- 平衡场景:nodelay=1, interval=20, resend=2, nc=0

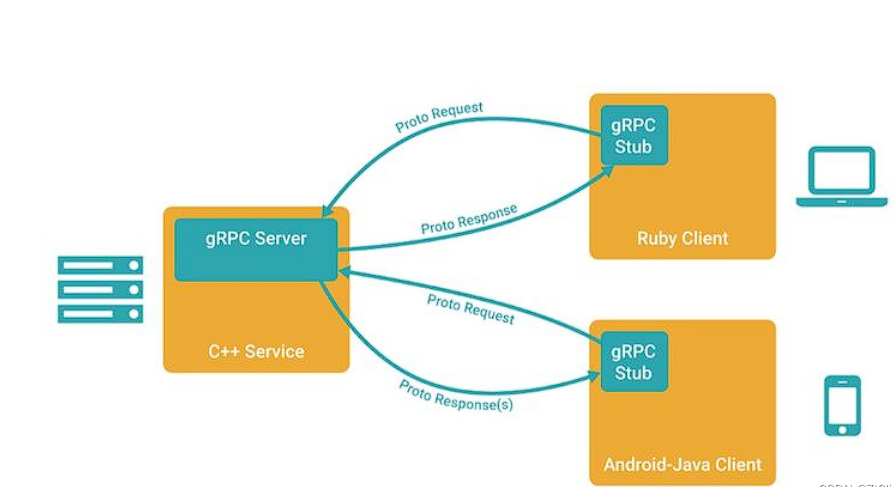

gRPC协议:现代化的RPC通信标准

gRPC这个协议我用得比较多,特别是在微服务架构中。它是Google开源的高性能RPC框架,基于HTTP/2协议,使用Protocol Buffers作为序列化格式。

刚开始接触gRPC的时候,我被它的性能震惊了。之前用REST API,JSON序列化反序列化很耗时,网络传输的数据量也大。gRPC用protobuf二进制序列化,数据量能减少30-50%,序列化速度也快很多。

gRPC有几个让我特别喜欢的特性:

多语言支持:这个真的很重要。我们团队有人用Go,有人用Python,还有人用Java。gRPC可以让不同语言的服务无缝通信,只需要定义好protobuf文件就行。

// 定义服务接口

service UserService {

rpc GetUser(GetUserRequest) returns (GetUserResponse);

rpc ListUsers(ListUsersRequest) returns (stream GetUserResponse);

}

message GetUserRequest {

int64 user_id = 1;

}

message GetUserResponse {

int64 user_id = 1;

string name = 2;

string email = 3;

}流式传输:gRPC支持四种调用方式:一元调用、服务端流、客户端流、双向流。我在做日志收集系统时用过客户端流,客户端可以持续发送日志数据,服务端统一处理,效率很高。

HTTP/2的优势:多路复用、头部压缩、服务端推送这些HTTP/2的特性,gRPC都能用上。特别是多路复用,一个连接可以并发处理多个请求,大大提高了效率。

负载均衡和服务发现:gRPC内置了负载均衡机制,支持多种策略:轮询、随机、一致性哈希等。配合服务发现组件,可以很容易实现服务的动态扩缩容。

我在实际使用中总结了一些经验:

连接管理很重要:gRPC的连接是长连接,需要合理管理连接池。我一般会设置合适的连接数和超时时间:

// Go语言的gRPC连接配置

conn, err := grpc.Dial(

"localhost:50051",

grpc.WithInsecure(),

grpc.WithKeepaliveParams(keepalive.ClientParameters{

Time: 10 * time.Second,

Timeout: 3 * time.Second,

PermitWithoutStream: true,

}),

)错误处理要完善:gRPC有自己的错误码体系,比HTTP状态码更丰富。要根据不同的错误码做相应的处理,比如UNAVAILABLE错误可以重试,INVALID_ARGUMENT错误就不应该重试。

监控和追踪:gRPC天然支持分布式追踪,配合OpenTelemetry可以很容易实现链路追踪。我一般会加上这些监控指标:请求延迟、成功率、QPS等。

gRPC也有一些局限性。首先是调试相对困难,不像HTTP那样可以直接用浏览器或curl测试。需要专门的工具,比如grpcurl或者BloomRPC。

其次是对网络环境要求较高。gRPC基于HTTP/2,有些老的代理服务器或负载均衡器可能不支持。我就遇到过公司的老代理不支持HTTP/2,导致gRPC连接失败的情况。

还有就是学习成本。protobuf的语法、gRPC的各种配置选项,都需要时间去掌握。不过一旦熟悉了,开发效率会大大提升。

在性能方面,gRPC确实很出色。我做过对比测试,同样的业务逻辑,gRPC比REST API快20-30%,数据传输量也小很多。特别是在内网环境下,gRPC的优势更明显。

xHTTP:灵活的HTTP扩展

xHTTP这个协议说实话我接触得不多,但在某些特殊场景下确实很有用。它本质上是对HTTP协议的扩展,增加了一些自定义的功能。

xHTTP的设计理念是在保持HTTP兼容性的同时,提供更多的传输选项。比如可以自定义头部字段,支持更灵活的数据编码方式等。

我记得有一次做项目对接,对方系统只支持HTTP,但又需要一些HTTP标准里没有的功能。这时候xHTTP就派上用场了。通过自定义头部字段,我们实现了一些额外的功能,同时保持了协议的兼容性。

xHTTP的配置相对简单,主要是定义一些自定义字段和编码规则:

# xHTTP配置示例

xhttp:

custom_headers:

- "X-Custom-Auth"

- "X-Request-ID"

encoding: "gzip"

max_body_size: "10MB"不过说实话,xHTTP的使用场景比较有限。如果不是有特殊需求,一般还是用标准HTTP就够了。

HTTP Upgrade:平滑的协议升级

HTTP Upgrade机制我觉得设计得很巧妙。它允许客户端和服务器在已建立的HTTP连接基础上,升级到其他协议。

最常见的就是WebSocket的升级过程。客户端先发送一个普通的HTTP请求,但在请求头里加上Upgrade字段,告诉服务器想要升级协议。如果服务器同意,就返回101状态码,然后连接就升级成功了。

GET /chat HTTP/1.1

Host: example.com

Upgrade: websocket

Connection: Upgrade

Sec-WebSocket-Key: dGhlIHNhbXBsZSBub25jZQ==

Sec-WebSocket-Version: 13这种机制的好处是对现有网络设施友好。很多代理服务器、负载均衡器都支持HTTP,但可能不支持其他协议。通过HTTP Upgrade,可以先建立HTTP连接,然后再升级到目标协议。

我在实际使用中发现,HTTP Upgrade在穿越防火墙和代理时特别有用。因为初始连接是标准HTTP,大部分网络设备都会放行。等升级完成后,就可以使用目标协议的所有功能了。

但是HTTP Upgrade也有局限性。升级过程需要额外的握手,会增加一些延迟。而且不是所有协议都适合通过HTTP升级,需要协议本身支持这种机制。

实际应用场景分析

在实际项目中,选择哪种传输协议真的很重要。我总结了一下自己的经验:

如果是实时性要求很高的应用,比如游戏、实时交易系统,我会优先考虑KCP。虽然带宽消耗大一些,但延迟确实低。

对于一般的Web应用,WebSocket就够用了。配置简单,性能也不错。不过要注意网络环境的兼容性问题。

如果需要和现有HTTP系统集成,xHTTP是个不错的选择。可以在保持兼容性的同时,增加一些自定义功能。

HTTP Upgrade适合需要穿越复杂网络环境的场景。先用HTTP建立连接,再升级到目标协议,兼容性最好。

部署和运维注意事项

部署这些协议时,运维层面也有不少要注意的地方。

负载均衡器的配置很关键。WebSocket需要会话保持,不能简单的轮询分发。我之前就遇到过,负载均衡器把同一个WebSocket连接的请求分发到不同服务器,导致连接异常。

防火墙规则要提前配置好。KCP使用UDP协议,很多防火墙默认会拦截。需要提前开放相应的端口。

SSL/TLS的配置也要注意。WebSocket over SSL(WSS)的配置和普通HTTPS有些差异,证书和加密套件的选择要合适。

容器化部署时,网络模式的选择很重要。我用Docker部署KCP应用时,发现host网络模式的性能比bridge模式好很多。

写在最后

回顾这段时间的实践,我觉得选择传输协议就像选择交通工具一样。

WebSocket像是地铁,速度快,但对基础设施要求高。

KCP像是出租车,灵活快速,但成本较高。

xHTTP像是公交车,经济实用,但功能有限。

HTTP Upgrade像是换乘,可以到达更多地方,但需要中转。

每种协议都有自己的适用场景,关键是要根据实际需求做出合理选择。不要盲目追求新技术,也不要固守旧方案,适合的才是最好的。

技术在不断发展,我们也要保持学习的心态。今天分享的这些经验可能过几年就过时了,但学习和思考的方法是不会变的。

希望我的这些经验能对大家有所帮助。如果你在使用这些协议时遇到问题,欢迎交流讨论。毕竟技术这东西,一个人摸索总是有限的,大家一起分享才能走得更远。

网络协议这个领域还有很多值得探索的地方,我也在继续学习中。期待和大家一起在技术的道路上不断前进!

如果这篇文章对你有帮助,别忘了点赞转发支持一下!想了解更多运维实战经验和技术干货,记得关注微信公众号@运维躬行录,领取学习大礼包!!!我会持续分享更多接地气的运维知识和踩坑经验。让我们一起在运维这条路上互相学习,共同进步!

公众号:运维躬行录

个人博客:躬行笔记