KVM虚拟化深度实战:从入门到生产环境部署的完整指南

KVM (Kernel-based Virtual Machine) 是云计算的重要基础技术之一。KVM是一种开源的虚拟化解决方案,它将Linux内核转变为一个虚拟机监视器(hypervisor),允许主机运行多个隔离的虚拟环境(虚拟机)。今天就把这些年用KVM的心得体会整理出来,从基础概念到生产环境部署,尽量把每个细节都讲清楚。毕竟虚拟化这个东西,细节决定成败,一个小配置错误可能就会导致整个环境不稳定。

KVM到底是个什么东西

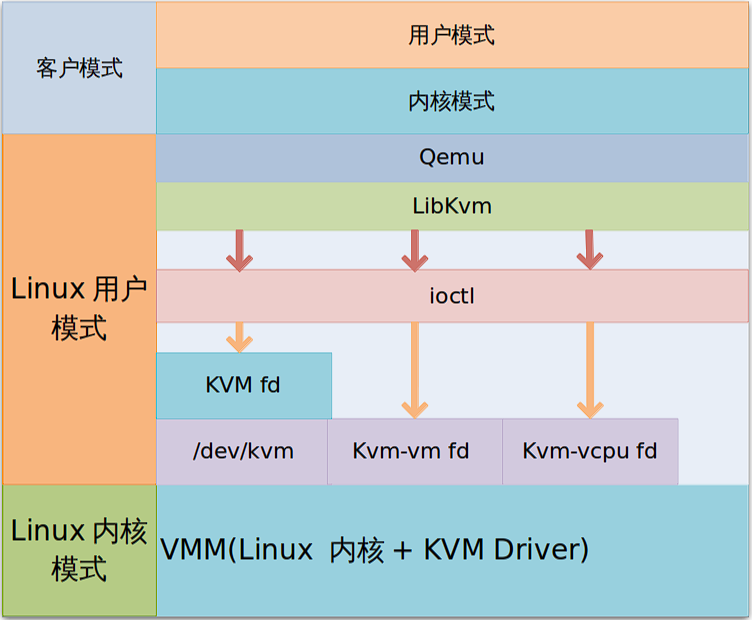

KVM全称是Kernel-based Virtual Machine,翻译过来就是基于内核的虚拟机。它是Linux内核的一个模块,可以让Linux系统变成一个虚拟机监控器(Hypervisor)。

说白了,KVM就是让你的Linux服务器能够同时运行多个虚拟机的技术。每个虚拟机都有自己独立的操作系统、CPU、内存、存储和网络资源,但实际上都是共享宿主机的硬件资源。

KVM属于Type-1类型的虚拟化技术,也就是直接运行在硬件上的虚拟化层。这种架构的好处是性能损耗小,虚拟机的性能接近物理机。相比之下,VMware Workstation这种Type-2虚拟化就要先在宿主操作系统上运行,性能会有一定损失。

我记得刚开始接触虚拟化的时候,总是搞不清楚KVM、QEMU、libvirt这些概念的关系。后来才明白,KVM负责CPU和内存的虚拟化,QEMU负责I/O设备的模拟,libvirt则是管理接口。三者配合起来才构成了完整的虚拟化解决方案。

硬件要求和环境准备

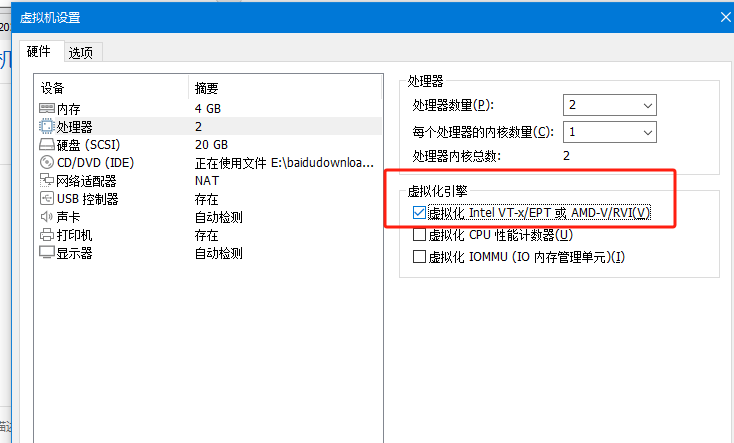

想要使用KVM,首先硬件得支持虚拟化扩展。Intel的CPU需要支持VT-x技术,AMD的CPU需要支持AMD-V技术。现在的服务器CPU基本都支持,但有些主板的BIOS默认是关闭的,需要手动开启。

在虚拟机测试的话需要勾选这个!

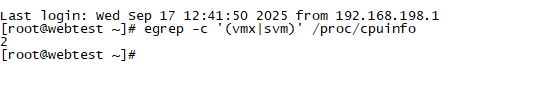

检查CPU是否支持虚拟化很简单:

# 检查CPU虚拟化支持

egrep -c '(vmx|svm)' /proc/cpuinfo

如果输出的数字大于0,就说明CPU支持虚拟化。还可以用这个命令看更详细的信息:

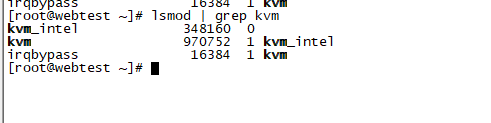

lscpu | grep Virtualization除了CPU支持,还需要确保内核加载了KVM模块:

lsmod | grep kvm如果没有输出,需要手动加载:

sudo modprobe kvm

sudo modprobe kvm_intel # Intel CPU

# 或者

sudo modprobe kvm_amd # AMD CPU

内存方面,建议至少8GB以上,因为宿主机本身要占用一部分内存,剩下的才能分配给虚拟机。我一般会预留2-4GB给宿主机,其余的都分配给虚拟机。

存储空间也要充足,每个虚拟机的磁盘文件动辄几十GB,再加上快照文件,存储需求还是挺大的。建议使用SSD,虚拟机的I/O性能会好很多。

安装和配置KVM环境

不同的Linux发行版安装KVM的方法略有差异,但基本流程都差不多。

Ubuntu/Debian系统:

sudo apt update

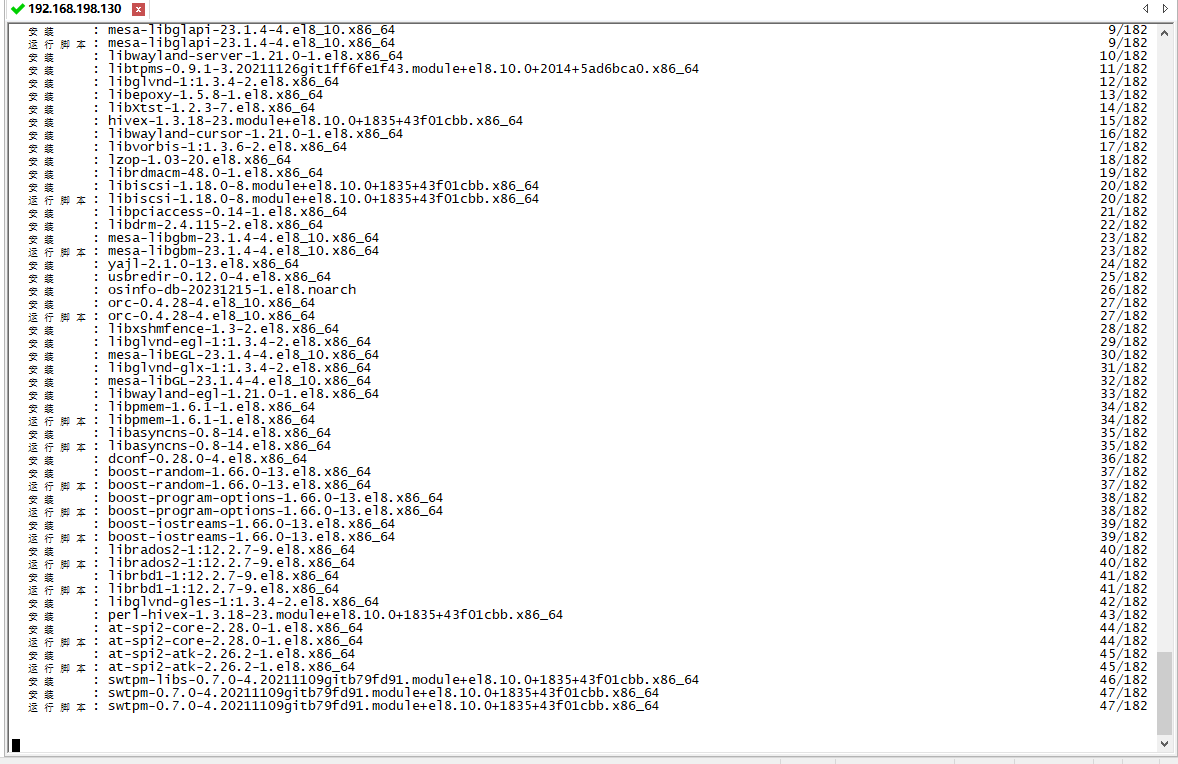

sudo apt install qemu-kvm libvirt-daemon-system libvirt-clients bridge-utils virt-managerCentOS/RHEL系统:

sudo yum install qemu-kvm libvirt python3-libvirt libguestfs-tools virt-install virt-manager

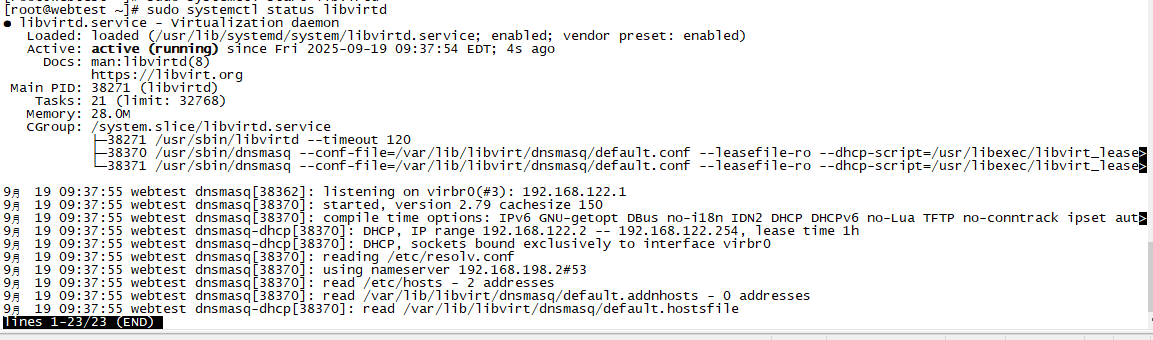

安装完成后,需要启动libvirt服务:

sudo systemctl enable libvirtd

sudo systemctl start libvirtd为了方便管理,建议把当前用户加入到libvirt组:

sudo usermod -a -G libvirt $USER然后重新登录或者执行newgrp libvirt使组权限生效。

验证安装是否成功:

virsh list --all如果能正常输出(即使是空列表),就说明安装成功了。

网络配置详解

KVM的网络配置是个比较复杂的话题,不同的网络模式适用于不同的场景。

NAT模式是最简单的,虚拟机通过宿主机的NAT网关访问外网,但外网无法直接访问虚拟机。这种模式适合开发测试环境。

libvirt默认会创建一个名为"default"的NAT网络:

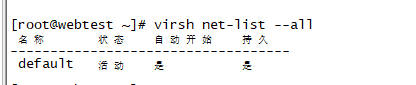

virsh net-list --all

可以看到default网络的配置:

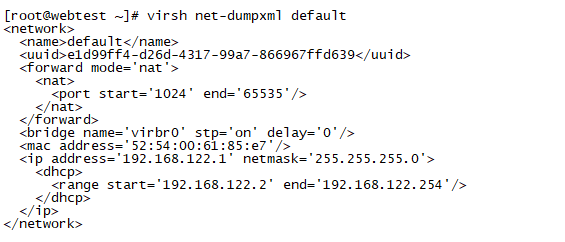

virsh net-dumpxml default

默认配置解释:

- 网络名称为"default"

- 使用NAT转发模式(

<forward mode='nat'>) - 创建了一个名为"virbr0"的虚拟网桥

- 网桥的IP地址为192.168.122.1,子网掩码为255.255.255.0

- 配置了DHCP服务,为虚拟机分配从192.168.122.2到192.168.122.254的IP地址

桥接模式让虚拟机直接连接到物理网络,虚拟机可以获得和宿主机同网段的IP地址。这种模式适合生产环境。

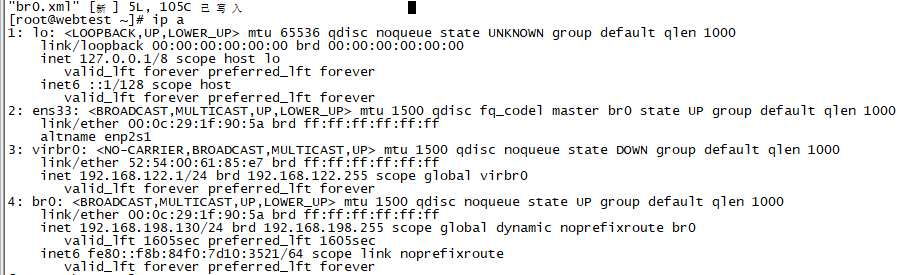

创建桥接网络需要先配置网桥。在Rocky Linux release 8.10系统中,可以通过以下命令配置网桥

#创建桥接接口

sudo nmcli con add type bridge con-name br0 ifname br0

#配置桥接接口的 IP 设置(DHCP)

sudo nmcli con mod br0 ipv4.method auto

#静态 IP(动态静态二选一就好)

sudo nmcli con mod br0 ipv4.addresses 192.168.1.10/24

sudo nmcli con mod br0 ipv4.gateway 192.168.1.1

sudo nmcli con mod br0 ipv4.dns "8.8.8.8,8.8.4.4"

sudo nmcli con mod br0 ipv4.method manual

#将物理网卡添加到桥接

sudo nmcli con add type bridge-slave con-name ens33-bridge ifname ens33 master br0

#启用桥接接口并禁用原网卡连接,执行的时候要注意会断网!!!

sudo nmcli con down ens33|sudo nmcli con up br0

然后在libvirt中定义这个网桥:

<network>

<name>br0</name>

<forward mode="bridge"/>

<bridge name="br0"/>

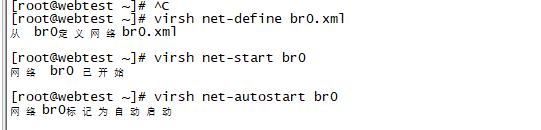

</network>保存为br0.xml,然后导入:

virsh net-define br0.xml

virsh net-start br0

virsh net-autostart br0

隔离网络让虚拟机之间可以通信,但无法访问外网。这种模式适合搭建隔离的测试环境。

创建隔离网络的配置文件:

<network>

<name>isolated</name>

<bridge name="virbr1"/>

<ip address="192.168.100.1" netmask="255.255.255.0">

<dhcp>

<range start="192.168.100.2" end="192.168.100.254"/>

</dhcp>

</ip>

</network>网络配置这块确实比较复杂,我刚开始的时候也是搞了很久才理解。建议先从NAT模式开始,熟悉了基本操作再尝试其他网络模式。

存储管理的最佳实践

KVM支持多种存储格式,每种都有自己的特点和适用场景。

qcow2格式是最常用的,支持快照、压缩、加密等高级功能。文件大小会根据实际使用情况动态增长,节省存储空间。但性能会比raw格式稍差一些。

创建qcow2格式的磁盘:

qemu-img create -f qcow2 /var/lib/libvirt/images/vm1.qcow2 20Graw格式性能最好,但不支持快照等高级功能,而且会立即占用指定的磁盘空间。适合对性能要求很高的场景。

qemu-img create -f raw /var/lib/libvirt/images/vm1.raw 20G存储池是libvirt的一个重要概念,可以统一管理存储资源。默认的存储池位于/var/lib/libvirt/images/,但你可以创建自己的存储池:

# 创建目录存储池

virsh pool-define-as mypool dir - - - - "/data/vms"

virsh pool-build mypool

virsh pool-start mypool

virsh pool-autostart mypool还可以创建LVM存储池,性能会更好:

# 假设已经有一个名为vg_vms的卷组

virsh pool-define-as lvmpool logical - - vg_vms /dev/vg_vms

virsh pool-build lvmpool

virsh pool-start lvmpool快照管理是qcow2格式的一大优势。可以在虚拟机运行时创建快照:

# 创建快照

virsh snapshot-create-as vm1 snapshot1 "测试前的备份"

# 列出快照

virsh snapshot-list vm1

# 恢复快照

virsh snapshot-revert vm1 snapshot1

# 删除快照

virsh snapshot-delete vm1 snapshot1不过要注意,快照会影响虚拟机的性能,而且快照文件会越来越大。生产环境中建议定期清理不需要的快照。

创建和管理虚拟机

创建虚拟机有多种方法,最直接的是使用virt-install命令:

virt-install \

--name vm1 \

--ram 2048 \

--vcpus 2 \

--disk path=/var/lib/libvirt/images/vm1.qcow2,size=20,format=qcow2 \

--network network=default \

--graphics vnc,listen=0.0.0.0 \

--cdrom /path/to/ubuntu-20.04.iso \

--os-type linux \

--os-variant ubuntu20.04这个命令会创建一个名为vm1的虚拟机,2GB内存,2个CPU,20GB硬盘,使用默认网络,并从ISO镜像启动安装系统。

虚拟机创建完成后,可以用这些命令管理:

# 启动虚拟机

virsh start vm1

# 关闭虚拟机

virsh shutdown vm1

# 强制关闭

virsh destroy vm1

# 查看虚拟机状态

virsh domstate vm1

# 查看虚拟机信息

virsh dominfo vm1

# 连接到虚拟机控制台

virsh console vm1如果虚拟机配置了VNC,还可以通过VNC客户端连接:

# 查看VNC端口

virsh vncdisplay vm1然后用VNC客户端连接到宿主机IP:端口就可以看到虚拟机的图形界面了。

动态调整资源是KVM的一个强大功能。可以在虚拟机运行时调整CPU和内存:

# 动态调整内存(需要虚拟机支持)

virsh setmem vm1 4096M --live

# 动态调整CPU

virsh setvcpus vm1 4 --live不过这个功能有一些限制,比如内存只能增加不能减少,而且需要客户机操作系统的支持。

性能优化技巧

KVM虚拟机的性能优化是个很大的话题,这里分享一些实用的技巧。

CPU优化方面,可以启用CPU的host-passthrough模式,让虚拟机直接使用宿主机的CPU特性:

<cpu mode='host-passthrough' check='none'/>还可以绑定CPU核心,避免CPU调度开销:

<vcpu placement='static' cpuset='2-3'>2</vcpu>内存优化可以启用大页内存,减少TLB miss:

# 配置大页内存

echo 1024 > /sys/kernel/mm/hugepages/hugepages-2048kB/nr_hugepages然后在虚拟机配置中启用:

<memoryBacking>

<hugepages/>

</memoryBacking>存储优化方面,可以使用virtio-scsi驱动,性能比默认的IDE要好很多:

<disk type='file' device='disk'>

<driver name='qemu' type='qcow2' cache='none' io='native'/>

<source file='/var/lib/libvirt/images/vm1.qcow2'/>

<target dev='sda' bus='scsi'/>

</disk>

<controller type='scsi' index='0' model='virtio-scsi'/>网络优化可以使用virtio网卡驱动,并启用多队列:

<interface type='bridge'>

<source bridge='br0'/>

<model type='virtio'/>

<driver name='vhost' queues='4'/>

</interface>多队列网络可以显著提升网络性能,特别是在高并发场景下。队列数量一般设置为虚拟机CPU核心数。

还有一个容易忽略的优化点是关闭不必要的设备模拟。比如如果不需要软驱,可以在配置中去掉:

<!-- 删除这行 -->

<disk type='file' device='floppy'>NUMA优化在多CPU的服务器上很重要。可以查看宿主机的NUMA拓扑:

numactl --hardware然后在虚拟机配置中指定NUMA节点:

<numatune>

<memory mode='strict' nodeset='0'/>

</numatune>我之前遇到过一个性能问题,虚拟机的网络延迟特别高。后来发现是因为虚拟机的CPU分配跨了NUMA节点,导致内存访问延迟增加。调整NUMA配置后,延迟明显降低了。

高可用和容灾方案

生产环境中,高可用是必须考虑的问题。KVM提供了几种实现高可用的方案。

虚拟机热迁移是最常用的高可用技术。可以在不停机的情况下将虚拟机从一台宿主机迁移到另一台:

# 热迁移虚拟机

virsh migrate --live vm1 qemu+ssh://target-host/system热迁移需要满足一些条件:

- 两台宿主机的CPU要兼容

- 需要共享存储(NFS、iSCSI等)

- 网络配置要一致

- 时间要同步

我记得第一次做热迁移的时候,总是失败。后来发现是因为两台服务器的CPU型号不同,虽然都是Intel的,但微架构不一样。最后通过在虚拟机配置中指定通用的CPU模型解决了:

<cpu mode='custom' match='exact'>

<model fallback='allow'>Westmere</model>

</cpu>共享存储是实现高可用的关键。可以使用NFS、iSCSI、GlusterFS等方案。我比较喜欢用NFS,配置简单,性能也够用:

# NFS服务器配置

echo "/data/vms *(rw,sync,no_root_squash)" >> /etc/exports

systemctl restart nfs-server

# 客户端挂载

mount -t nfs nfs-server:/data/vms /var/lib/libvirt/images集群管理可以使用Pacemaker + Corosync实现自动故障转移。不过配置比较复杂,小规模环境可能用不上。

备份策略也很重要。除了传统的文件备份,还可以使用libvirt的备份API:

# 创建完整备份

virsh backup-begin vm1 --diskspec sda,backup=/backup/vm1-full.qcow2

# 创建增量备份

virsh backup-begin vm1 --diskspec sda,backup=/backup/vm1-inc.qcow2,bitmap=backup1不过这个功能比较新,需要较新版本的libvirt支持。

监控和日志管理

监控对于虚拟化环境来说特别重要,因为一台物理机上运行着多个虚拟机,出问题影响面比较大。

资源监控可以使用virsh命令:

# 查看虚拟机资源使用情况

virsh domstats vm1

# 实时监控

watch -n 1 'virsh domstats vm1'还可以使用virt-top工具,类似于top命令:

virt-top性能监控可以收集更详细的指标:

# 查看虚拟机的CPU使用情况

virsh cpu-stats vm1

# 查看内存统计

virsh dommemstat vm1

# 查看磁盘I/O统计

virsh domblkstat vm1 sda日志管理方面,libvirt的日志默认记录在/var/log/libvirt/目录下。可以调整日志级别:

# 编辑libvirt配置

sudo vim /etc/libvirt/libvirtd.conf

# 设置日志级别

log_level = 2

log_outputs = "2:file:/var/log/libvirt/libvirtd.log"虚拟机的控制台日志也很有用,特别是排查启动问题的时候:

# 查看虚拟机控制台日志

virsh console vm1 --force我一般会配置logrotate来管理日志文件,避免日志文件过大:

# /etc/logrotate.d/libvirt

/var/log/libvirt/*.log {

daily

rotate 7

compress

delaycompress

missingok

notifempty

create 0644 root root

postrotate

systemctl reload libvirtd

endscript

}安全配置要点

虚拟化环境的安全配置不能马虎,这里总结几个重要的安全要点。

网络隔离是基础。不同用途的虚拟机应该放在不同的网络中,避免横向攻击:

<network>

<name>dmz</name>

<bridge name="virbr-dmz"/>

<ip address="10.0.1.1" netmask="255.255.255.0">

<dhcp>

<range start="10.0.1.100" end="10.0.1.200"/>

</dhcp>

</ip>

</network>防火墙配置要合理。libvirt会自动创建一些iptables规则,但可能需要根据实际需求调整:

# 查看libvirt创建的防火墙规则

iptables -L -n -v

# 允许特定端口访问虚拟机

iptables -I FORWARD -d 192.168.122.100 -p tcp --dport 80 -j ACCEPTSELinux配置在RHEL/CentOS系统中很重要:

# 检查SELinux状态

sestatus

# 设置虚拟机文件的SELinux上下文

setsebool -P virt_use_nfs 1

restorecon -R /var/lib/libvirt/images/磁盘加密可以保护虚拟机数据:

# 创建加密磁盘

qemu-img create -f qcow2 --object secret,id=sec0,data=mypassword \

-o encrypt.format=luks,encrypt.key-secret=sec0 encrypted.qcow2 10G访问控制要严格管理。不要随便给用户libvirt权限:

# 创建专门的虚拟化管理组

sudo groupadd vmadmin

sudo usermod -a -G vmadmin username

# 配置sudo权限

echo "%vmadmin ALL=(ALL) /usr/bin/virsh" >> /etc/sudoers.d/vmadmin我之前遇到过一个安全事件,有个虚拟机被入侵了,攻击者试图通过虚拟机逃逸到宿主机。幸好配置了适当的隔离措施,没有造成更大的损失。这件事让我深刻认识到虚拟化环境安全配置的重要性。

故障排查实战经验

虚拟机启动失败是最常见的问题。首先查看libvirt日志:

sudo journalctl -u libvirtd -f还可以查看虚拟机的详细错误信息:

virsh start vm1 --console有时候是权限问题,检查磁盘文件的权限:

ls -la /var/lib/libvirt/images/

chown libvirt-qemu:libvirt-qemu /var/lib/libvirt/images/vm1.qcow2性能问题可以通过这些方法排查:

# 查看宿主机资源使用

top

iostat -x 1

sar -u 1

# 查看虚拟机资源使用

virsh domstats vm1我遇到过一个奇怪的性能问题,虚拟机的磁盘I/O特别慢。后来发现是因为磁盘文件放在了一个很慢的机械硬盘上,而且还开启了磁盘缓存。关闭缓存后性能有所改善,但最终还是迁移到了SSD上。

网络连通性问题的排查:

# 检查网桥状态

brctl show

ip link show

# 检查防火墙规则

iptables -L -n -v

# 检查虚拟机网络配置

virsh domiflist vm1

virsh domifstat vm1 vnet0存储问题通常和空间或权限有关:

# 检查存储池状态

virsh pool-list --all

virsh pool-info default

# 检查磁盘空间

df -h

du -sh /var/lib/libvirt/images/*

# 检查磁盘文件完整性

qemu-img check /var/lib/libvirt/images/vm1.qcow2有一次遇到虚拟机突然无法启动的问题,错误信息很模糊。最后发现是因为磁盘文件损坏了,可能是因为宿主机异常关机导致的。幸好有备份,恢复后就正常了。这件事让我意识到定期备份的重要性。

与容器技术的对比

现在容器技术很火,经常有人问KVM和Docker哪个好。其实这两个技术各有优势,适用场景不同。

隔离性方面,KVM提供更强的隔离。每个虚拟机都有独立的内核,安全性更好。容器共享宿主机内核,隔离性相对较弱。

资源开销方面,容器的优势明显。容器启动快,资源占用少。虚拟机需要完整的操作系统,开销比较大。

管理复杂度上,容器更简单。Docker的使用门槛比KVM低很多,学习曲线平缓。

适用场景不同:

- KVM适合需要运行不同操作系统的场景

- KVM适合需要强隔离的场景

- 容器适合微服务架构

- 容器适合CI/CD流水线

实际项目中,我们经常是混合使用。用KVM搭建基础设施,在虚拟机里运行容器应用。这样既有了强隔离,又有了容器的便利性。

与云平台的集成

现在很多公司都在向云原生转型,KVM作为基础设施层,需要和各种云平台集成。

OpenStack是最常见的私有云平台,底层就是基于KVM的。如果你熟悉KVM,理解OpenStack会容易很多。OpenStack的Nova组件就是管理KVM虚拟机的。

oVirt是红帽的虚拟化管理平台,提供了Web界面来管理KVM虚拟机。对于不熟悉命令行的用户来说比较友好。(下次来介绍介绍它)

Proxmox VE是另一个不错的选择,集成了KVM和LXC容器,还有Web管理界面。我在一些小项目中用过,体验还不错。

Kubernetes也可以运行在KVM虚拟机上。我们的K8s集群就是部署在KVM虚拟机中的,这样可以更好地控制资源分配和网络配置。

# 用于K8s节点的虚拟机配置示例

apiVersion: v1

kind: ConfigMap

metadata:

name: vm-config

data:

vm-template.xml: |

<domain type='kvm'>

<name>k8s-node</name>

<memory unit='KiB'>4194304</memory>

<vcpu placement='static'>2</vcpu>

<cpu mode='host-passthrough'/>

...

</domain>未来发展趋势

虚拟化技术还在不断发展,KVM也在持续演进。

嵌套虚拟化让你可以在虚拟机里再运行虚拟机,这在某些测试场景中很有用:

# 启用嵌套虚拟化

echo "options kvm_intel nested=1" >> /etc/modprobe.d/kvm.confGPU虚拟化让虚拟机可以使用GPU资源,这对AI/ML工作负载很重要。NVIDIA的vGPU技术可以让多个虚拟机共享一块GPU。

容器和虚拟机的融合也是个趋势。像Kata Containers这样的技术,用虚拟机来运行容器,既有容器的便利性,又有虚拟机的安全性。

边缘计算场景中,轻量级的虚拟化技术需求增加。KVM也在向这个方向发展,比如通过优化启动时间、减少内存占用等。

我觉得虚拟化技术不会被容器完全替代,而是会在不同场景中发挥各自的优势。KVM作为成熟稳定的虚拟化技术,在企业级应用中还会继续发挥重要作用。

总结

KVM作为Linux平台上最重要的虚拟化技术之一,在企业IT基础设施中发挥着重要作用。从基本的虚拟机创建到复杂的高可用集群,KVM都能胜任。虽然现在容器技术很火,但虚拟机技术并不会消失。在需要强隔离、运行不同操作系统、或者对安全性要求很高的场景中,KVM仍然是最佳选择。掌握KVM不仅能帮你更好地管理基础设施,还能让你更深入地理解虚拟化原理。这些知识在云计算时代仍然很有价值,毕竟大部分云平台的底层都是基于KVM的。希望这篇文章能帮到正在学习或使用KVM的朋友们。虚拟化这个领域知识点很多,需要不断学习和实践。如果你在使用过程中遇到问题,欢迎交流讨论。

技术这东西,光看不练是学不会的。建议大家找台服务器或者用虚拟机搭个环境,亲自动手试试。只有在实践中踩过坑,才能真正掌握这些技术。

如果这篇文章对你有帮助,别忘了点赞转发支持一下!想了解更多运维实战经验和技术干货,记得关注微信公众号@运维躬行录,领取学习大礼包!!!我会持续分享更多接地气的运维知识和踩坑经验。让我们一起在运维这条路上互相学习,共同进步!

公众号:运维躬行录

个人博客:躬行笔记